Mengapa AMD dan Nvidia jadi Rival di pengembangan AI

Daftar Isi

Hal ini karena vendor tidak terbiasa menunjukkan chip atau produk mereka kalah bersaing, sehingga hasil terbaik biasanya dipilih, disesuaikan, dan dioptimalkan untuk menampilkannya sebagai pemenang.

Perbandingan ini biasanya tidak mendapat tanggapan dari pembuat chip pesaingnya, namun dalam kasus GPU MI300X AMD yang baru diluncurkan, Nvidia merasa perlu untuk angkat bicara. Dalam postingan blognya minggu lalu, spesialis akselerator menolak keakuratan dan relevansi benchmark AMD.

Nvidia begitu bersemangat

Pada hari Jumat (15/12/2023), AMD merespons dengan membagikan serangkaian angka yang dioptimalkan, mengklaim keunggulan kinerja bahkan ketika mempertimbangkan perpustakaan perangkat lunak Nvidia yang dioptimalkan dan dukungan untuk presisi yang lebih rendah.

Selama acara peluncuran AMD akhir Desember 2023, pembuat chip tersebut mengklaim MI300X miliknya – yang merupakan varian GPU dari chip tersebut – mampu mencapai latensi 40 persen lebih rendah dibandingkan H100 ketika menyimpulkan model parameter Llama 2 70 miliar Meta.

Masalahnya, menurut Nvidia, benchmark AMD tidak memanfaatkan perangkat lunaknya yang dioptimalkan atau dukungan H100 untuk tipe data FP8, dan malah dilakukan menggunakan vLLM di FP16. Secara umum, tipe data dengan presisi yang lebih rendah memperdagangkan akurasi untuk kinerja. Dengan kata lain, Nvidia mengatakan AMD menahan H100.

Nvidia mengklaim H100-nya mengungguli AMD MI300X ketika menggunakan tumpukan perangkat lunak pilihan pembuat chip dan presisi FP8. Image credit: Nvidia

Nvidia mengklaim bahwa ketika melakukan benchmark menggunakan kerangka kerja TensorRT LLM sumber tertutup dan FP8, H100 sebenarnya dua kali lebih cepat dari MI300X.

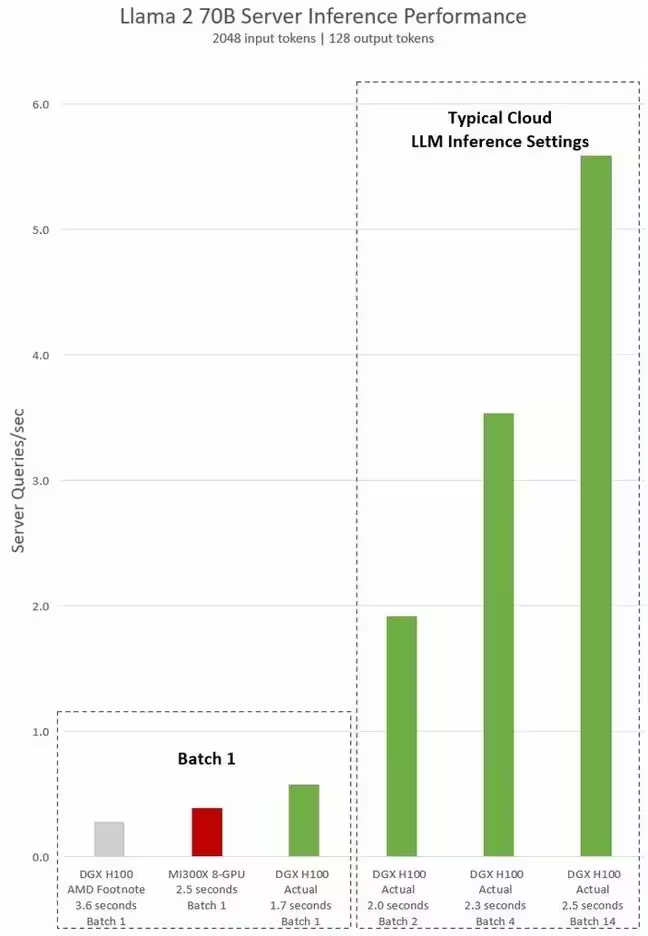

Nvidia juga berpendapat bahwa AMD menghadirkan skenario terbaik untuk kinerja di sini dengan menggunakan ukuran batch satu – dengan kata lain, dengan menangani satu permintaan inferensi pada satu waktu. Hal ini, menurut Nvidia, tidak realistis karena sebagian besar penyedia cloud akan menukar latensi dengan ukuran batch yang lebih besar.

Balasan AMD

Sehari setelah postingan Nvidia ditayangkan, AMD merespons dengan postingan blognya sendiri yang menyatakan bahwa tolok ukur Nvidia bukanlah perbandingan apple-to-apple.

Selain menggunakan tumpukan perangkat lunaknya yang dioptimalkan, AMD menunjukkan bahwa Nvidia membandingkan kinerja FP8 H100 dengan MI300X di FP16. Setiap kali Anda mengurangi separuh presisi, Anda menggandakan operasi floating point chip – jadi perbedaan ini tidak bisa dianggap remeh.

MI300X mendukung FP8. vLLM, yang digunakan dalam pengujian AMD, namun belum mendukung tipe data tersebut, jadi untuk menyimpulkan pada MI300X kami terjebak dengan benchmark FP16 untuk saat ini.

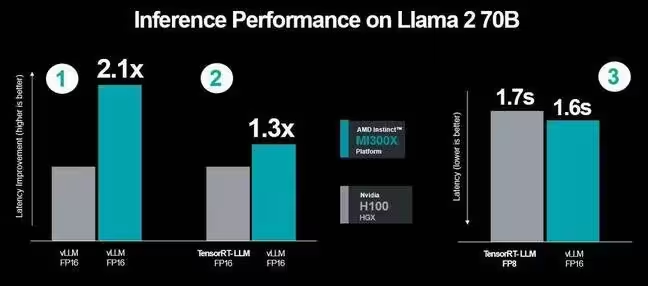

Bahkan ketika menggunakan tumpukan perangkat lunak pilihan Nvidia, AMD mengatakan kinerja MI300X-nya 30 persen lebih baik dalam inferensi AI FP16. Image credit: AMD

Selain memilah postingan blog Nvidia dan klaim kinerja, AMD menyajikan angka kinerja terbaru yang memanfaatkan optimasi baru. Kami telah membuat banyak kemajuan sejak kami mencatat data pada bulan November yang kami gunakan pada acara peluncuran kami, tulis postingan tersebut.

AMD mengklaim peningkatan ini meningkatkan keunggulan latensi MI300X di Llama 2 70B dari 1,4x menjadi 2,1x saat menggunakan kerangka kerja vLLM umum dengan akurasi FP16.

Topik dalam Artikel Ini

Artikel ini tersedia berkat dukungan Lita Purnama

Dan para kontributor lainnya yang mendukung MauCariApa.com.

seedbacklinkMarketplace backlink terbesar dan terpercaya di Indonesia

Marketplace backlink terbesar dan terpercaya di Indonesia

Diskusi & Komentar

Panduan Komentar

- • Gunakan bahasa yang sopan dan konstruktif

- • Hindari spam, promosi, atau link yang tidak relevan

- • Komentar akan terus dipantau secara berkala